Personas con dismorfia corporal entran en crisis tras pedir a la IA que califique su aspecto

“Esta es una presentación de lo que es poco atractivo, basada en una estructura ósea débil, rasgos apagados y ausencia de forma o presencia”, dice un mensaje de ChatGPT compartido a través de capturas de pantalla en Reddit. “Pareces alguien que se ha desvanecido en su propia vida”.

La dura evaluación de la apariencia del usuario, basada en una foto que había subido al chatbot de IA, continúa con una lista de los “defectos más visibles”, al tiempo que señala la falta de “rasgos que se destaquen”. Al final, el bot concluye: “Pareces un maniquí estirado con una cabeza del tamaño equivocado”, declarando una “Puntuación Final de Atractivo Brutal” de 3,5/10. El usuario explicó que había pedido a ChatGPT que fuera lo más crítico posible, con la esperanza de obtener un análisis más “honesto”, o al menos disminuir su tendencia a la adulación. El resultado fue maliciosamente ofensivo, con comentarios que nadie quisiera leer sobre sí mismo.

¿O sí? A medida que el mundo depende cada vez más de los grandes modelos de lenguaje para realizar tareas cotidianas, proliferan los usos extraños e inesperados. Más allá de los estudiantes universitarios y los profesores que recurren a los bots para sus tareas y calificaciones, y de los abogados que subcontratan a la IA para la revisión de documentos, hay personas que piden a ChatGPT —y herramientas similares— sesiones de terapia, ayuda para comunicarse con sus parejas, consejos para quedar en embarazo e iluminación religiosa.

Tal vez era inevitable que algunos consideraran a los bots como guías en cuestiones de su apariencia, pues Internet tiene una larga y sórdida historia con los juicios sobre belleza, desde sitios web ya desaparecidos como Hot or Not hasta r/amiugly, un subreddit donde puedes publicar selfies para que desconocidos opinen sobre tu rostro. Facemash, el sitio web que Mark Zuckerberg creó antes de Facebook, ofrecía a los estudiantes de Harvard la posibilidad de comparar el atractivo de compañeras de clase. Sin embargo, con la IA no es otro ser humano el que te da su opinión, sino un conjunto de algoritmos. Y hay un subgrupo de la población especialmente vulnerable a este tipo de comentarios: las personas con trastorno dismórfico corporal (TDC), enfermedad mental en la que el paciente se obsesiona con sus defectos físicos percibidos y puede caer en una autoevaluación constante.

Las personas que padecen trastorno dismórfico corporal evalúan compulsivamente lo que consideran sus defectos físicos.

La Dra. Toni Pikoos, psicóloga clínica de Melbourne (Australia) especializada en TDC, está preocupada porque muchos de sus clientes les están preguntando a modelos de IA cómo lucen y qué aspectos de su cuerpo pueden mejorar. “Sale a relucir en casi todas las sesiones”, explica a ROLLING STONE. “A veces le dicen: ‘Si alguien tiene la nariz así o la cara así, ¿es feo?’. O suben fotos suyas y le piden a ChatGPT que puntúe su atractivo sobre 10, que les diga qué tan simétrica es su cara, o cómo encaja en la proporción áurea de la belleza. También he tenido clientes que suben una foto suya y de un amigo y le dicen: ‘Dime quién es más atractivo y por qué’. Todo eso es muy perjudicial para cualquiera, pero especialmente para alguien con trastorno dismórfico corporal, pues ya tiene una percepción distorsionada de su aspecto y a menudo busca confirmaciones en torno a eso”.

“Lamentablemente, la IA es otra vía para que las personas alimenten su ansiedad en cuanto a su apariencia, y esto aumenta su malestar”, afirma Kitty Newman, directora general de la Fundación TDC, una organización benéfica internacional que apoya la educación y la investigación sobre este trastorno. “Sabemos que las personas con TDC son muy vulnerables al uso nocivo de la IA, ya que a menudo no saben de su trastorno, una condición psicológica, sino que están convencidas de que su problema es su apariencia física. Los altos niveles de vergüenza que conlleva el TDC hacen que a los afectados les resulte más fácil relacionarse en línea que en persona, lo que hace que la IA sea aún más atractiva”.

Pikoos explica que los pacientes con TDC suelen tener una necesidad compulsiva de reafirmación, y no es raro que amigos y familiares se sientan frustrados con las constantes preguntas sobre sus apariencias. Los chatbots, sin embargo, son inagotables. “Te va a permitir hacer las preguntas incesantemente si lo necesitas”, explica, lo que puede contribuir a la dependencia. De hecho, cree que las personas con TDC, dado que están “bastante aisladas socialmente y suelen tener problemas de confianza para acercarse a sus amigos”, están llegando a depender de los bots para sus interacciones sociales. “Sienten que pueden mantener una conversación con alguien”, afirma. Pero, claramente, la tecnología no es un “alguien” en lo absoluto.

En los foros de dismorfia corporal en línea, sin embargo, puedes encontrar un montón de mensajes sobre cómo ChatGPT es un “salvavidas” y un gran recurso para cuando estás “luchando”, y afirman que el bot puede hacerte “sentir visto”. Arnav, un joven de 20 años de la India, cuenta a ROLLING STONE que mantuvo una conversación positiva con la IA en un intento de entender por qué se sentía “la persona más fea del planeta” y, por lo tanto, indeseable.

“Me ayudó a atar cabos en mi vida”, afirma. Arnav contó a ChatGPT cómo fue su infancia, y el bot llegó a la conclusión de que había sufrido por mucho tiempo de un sentimiento irracional de ser indigno, pero que no tenía ninguna razón concreta para ello, así que se aferró a su aspecto como una explicación para su baja autoestima. Le “encantaría” hablar con un terapeuta de verdad, dice, aunque los costos y su locación se lo han impedido. A pesar de las difíciles circunstancias, y del consuelo que le proporcionó la explicación de ChatGPT sobre su complejo de inferioridad, Arnav es reacio a seguir explorando sus problemas mentales con el bot: “He llegado a la conclusión de que te da la razón, aunque le digas que no”, afirma. “No es que esté completamente en contra; ya no siento que pueda confiar ciegamente”.

Otras personas con dismorfia han experimentado crisis cuando un bot confirma sus peores temores. En una publicación en el subreddit BDD, una usuaria escribió que estaba “cayendo en espiral” después de que ChatGPT calificara una foto suya con un 5,5 sobre 10. “Pregunté qué celebridades tenían un atractivo equivalente y decía Lena Dunham y Amy Schumer”, escribió. “Fue bastante gracioso, pero también me siento una mierda conmigo misma ahora”. Otra persona publicó que genuinamente piensa que es atractiva cuando se ve al espejo, pero no cómo la ven los demás; subió a ChatGPT una foto suya normal y una versión “invertida”, y preguntó cuál se veía mejor. El bot eligió la imagen reflejada. “¡Lo sabía!”, escribió, “mi yo del espejo es demasiado buena para ser verdad. Es una modelo, la adoro. Pero, por desgracia, parece que somos dos chicas diferentes. No sé cómo lidiar con esto… es terrible”.

Pikoos afirma que esa “percepción distorsionada” es una manifestación clásica del TDC, una de las maneras en que un paciente se queda atrapado en querer saber cómo es objetivamente. Eso es parte del atractivo —y la peligrosidad— de los chatbots. “Suenan tan autoritarios” que la gente empieza a asumir que “la información que obtienen es objetiva e imparcial”, explica. Esto contrasta fuertemente con las reafirmaciones de amigos y familiares, o de un terapeuta, que pueden descartarse como mera cortesía. Un chatbot, en comparación, “no tiene nada que ganar, así que lo que diga debe ser la verdad”, dice Pikoos. “Y pienso que eso es muy aterrador, porque no necesariamente es así. Solo refleja la experiencia de la persona y también suele ser muy complaciente. Puede que les esté diciendo lo que esperan oír, y me estoy dando cuenta de que, durante la terapia, eso es más difícil de cuestionar”.

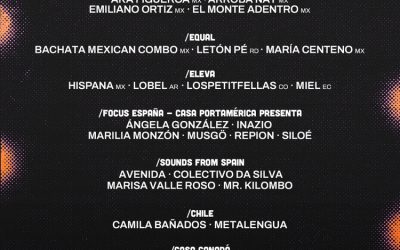

Esto es especialmente preocupante cuando entran en juego procedimientos cosméticos, dietas y tratamientos de belleza. El mes pasado, OpenAI retiró una versión de ChatGPT de su sitio web (uno de los principales modelos en la categoría “estilo de vida”) que recomendaba cirugías extremas y costosas a usuarios a los que evaluaba como “subhumanos”, produciendo análisis hostiles en un lenguaje que adoptó de las comunidades “incel”. Looksmaxxing GPT, como se llamaba, tuvo más de 700.000 conversaciones con usuarios antes de ser retirada. Naturalmente, desde entonces, han aparecido varios modelos similares en la plataforma de OpenAI con el mismo propósito, y los desarrolladores han creado sus propias aplicaciones basadas en IA que únicamente miden el atractivo o crean imágenes predictivas de cómo supuestamente te verías después de, por ejemplo, una operación de nariz o un lifting.

“Considero que estos bots crean expectativas poco realistas”, afirma Pikoos, “porque las cirugías no pueden hacer lo que puede hacer la IA”. Ella ofrece asesoría a pacientes que piensan hacerse cirugías estéticas, y dice que sus clientes luego consultan a los chatbots. “La respuesta inicial de ChatGPT suele ser: ‘No quiero darte consejos sobre tu aspecto o procedimientos cosméticos que necesites’”, dice Pikoos sobre sus propios experimentos con el bot. Pero si formulamos la pregunta como si se tratara de otra persona —preguntando, por ejemplo: “¿Cómo podría una persona con X, Y y Z, hacerse más atractiva según los estándares de belleza de la sociedad?”— la respuesta cambia. “Entonces ChatGPT dirá: ‘Bueno, podrían someterse a estos procedimientos’”, explica.

“Tengo clientes que han obtenido ese tipo de respuestas, lo cual es realmente preocupante”, afirma Pikoos. “Desde antes ya buscaban procedimientos cosméticos y formas de cambiar su aspecto. Pero, de nuevo, ahora se trata de consejos personalizados, más convincentes que algo que podrían encontrar en Google”. En su propia práctica, el “leer entre líneas” cuando alguien da sus razones para querer operarse puede revelar motivaciones poco saludables, como presiones sociales o problemas de pareja. “La IA no es muy buena detectando eso todavía”, dice, y es más probable que apruebe con entusiasmo cualquier procedimiento que proponga un usuario.

Otro motivo de preocupación —como ocurre con muchos servicios digitales— es la privacidad. Tanto si han sido diagnosticadas con TDC como si no, las personas que comparten sus fotos con estos modelos de IA también formulan preguntas muy íntimas que ponen al descubierto sus ansiedades más paralizantes. OpenAI ya ha señalado que ChatGPT puede mostrar anuncios a los usuarios a futuro; el CEO Sam Altman ha dicho que los anuncios personalizados por el algoritmo de Instagram son “una cosa genial”. ¿Podría la empresa acabar explotando datos personales sensibles de quienes utilizan el bot para evaluar sus cuerpos? Al revelar “las cosas que no les gustan de sí mismos, las cosas de las que se sienten acomplejados”, relata Pikoos, los usuarios pueden estarse predisponiendo a lanzamientos de “productos y procedimientos que potencialmente puedan ‘arreglar’ esas cosas, agravando el problema”.

Por eso a la doctora le inquietan las conversaciones que los pacientes con TDC han mantenido con programas de AI sobre sus aspectos y sus defectos. “En el peor de los casos, los síntomas empeoran”, dice. “Tengo la suerte de que las personas que vienen a terapia conmigo al menos pueden ser críticos con la información que obtienen de ChatGPT”. Pero para cualquiera que no esté en terapia y confíe mucho en el consejo de un chatbot, sus respuestas están destinadas a cobrar mayor importancia. La respuesta equivocada en el momento equivocado, dice Pikoos, puede llevar a pensamientos suicidas.

No es difícil dar instrucciones a un software para que nos evalúe con crueldad, la IA no puede saber cómo eso pone en riesgo a los usuarios, y tampoco entiende el frágil estado mental que puede haber detrás de esa petición. En todos los casos trágicos en los que un chatbot contribuye a que alguien se aleje de la realidad, se trata de la misma carencia central: una cosa simplemente no puede querer lo mejor para ti.